最近 Asahi-Net で PoE じゃなかった。 IPoE で IPv6 が利用可能になった。僕は他にも hi.net で IPv6 を /48 ほど借りているので二つのセグメントが利用可能なのであります。贅沢だぁ;-)。

と、いうことで自宅のネットワーク環境を見直してみました。

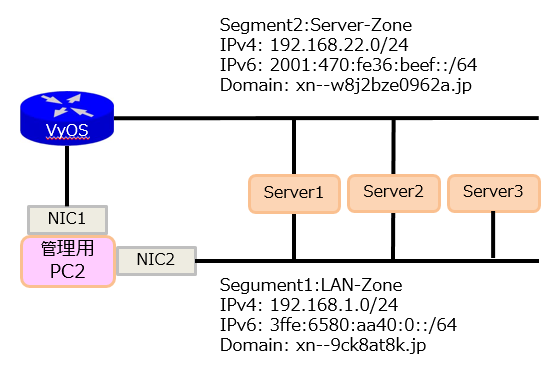

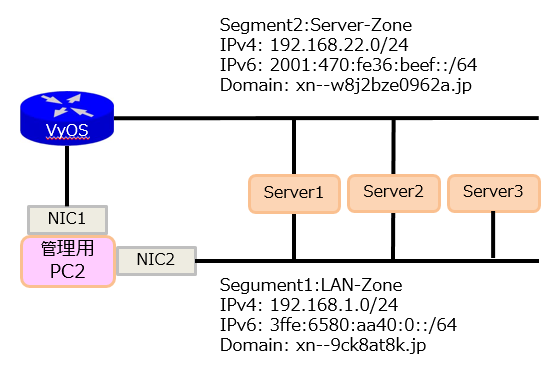

IPv4/IPv6 のセグメントをそれぞれ表側・裏側と二つ用意したんですね。

構成図はこんな感じ。 (多少、端折っているf(^^;;)

Server-Zone と LAN-Zone があり、管理用 PC2 は両方のセグメントに到達性があるわけなんですが、実際に運用してみると非常に厄介。

例えば管理用 PC2 には LAN-Zone の 192.168.1.100 が、 Server-Zone には 192.168.22.100 が付加されているとして Server1 の Server-Zone 側の IPv4 に ping を打つと元リは LAN-Zone 側から戻ってきてしまう。ぐるっと回ってしまうんですね。

パケットの流れ的には以下のような感じ。PC2 のソースアドレスは 192.168.1.100 で出て行きます。

管理用PC2 の NIC1 -> Server2 の Server-Zone -> Server2 の LAN-Zone -> 管理用 PC2 の NIC2

ぐるっと一周の旅です。これがグローバルアドレスだと、ISP 側では『自分の管理してないアドレスからバケットが届いた。』ということで破棄されます。

あぁ・・。サーバにポリシールーティングの設定入れないと・・。 orz

FreeBSD の場合、 ipfw の fwd でも pf でも、バケットが届いた NIC から出ていく。って設定ができないんですね。

パケットが届いた NIC のゲートウェイアドレスに返す。って設定はできるようなんですけど、その場合はゲートウェイ経由で届いたパケットは送信元に戻っていくけど、同一セグメント上のコネクテッドな送信元には戻っていかない。まいったなぁ・・。

上記の構成図のうち Server1 が Linux (CentOS 6.9) の場合、以下のように /etc/rc.local に書くと良いです。

ip route add 192.168.22.0/24 dev eth0 tab 100

ip route add 2001:470:fe36:beef::/64 dev eth0 tab 110

ip route add 192.168.1.0/24 dev eth1 tab 120

ip route add 3ffe:6580:aa40::/64 dev eth1 tab 130

ip route add default via 192.168.22.1 dev eth0 tab 100

ip route add default via 2001:470:fe36:beef::1 dev eth0 tab 110

ip route add default via 192.168.1.1 dev eth1 tab 120

ip route add default via 3ffe:6580:aa40::ffff:1 dev eth1 tab 130

ip rule add from 192.168.22.10/32 tab 100 priority 1000

ip -6 rule add from 2001:470:fe36:beef::2:1/64 tab 110 priority 1100

ip rule add from 192.168.1.10/32 tab 120 priority 1200

ip -6 rule add from 3ffe:6580:aa40::2:1/64 tab 130 priority 1300

ip route flush cache

|

・Server-Zone の IPv4 Gateway: 192.168.22.1

・Server-Zone のサーバ IPv4 アドレス: 192.168.22.10

・Server-Zone の IPv6 Gateway: 2001:470:fe36:beef::1

・Server-Zone のサーバ IPv6 アドレス: 2001:470:fe36:beef::2:1

・LAN-Zone の IPv4 Gateway: 192.168.1.1

・LAN-Zone のサーバ IPv4 アドレス: 192.168.1.10

・LAN-Zone の IPv6 Gateway: 3ffe:6580:aa40::ffff:1

・LAN-Zone のサーバ IPv6 アドレス: 3ffe:6580:aa40::2:1

route add と rule add を利用してポリシールーティングしてあげるとサクっと動作します。

最近の Linux のシステム管理者は default Gateway の設定はせず、ほとんど上記のようなポリシールーティングで設定を行い、セキュリティを強化しているようですねぇ。

FreeBSD の場合 ipfw の fwd では無理でした・・。僕にその知識が無いのかもしれないです・・。

なので、ファイアーウォールは ipfw だけど、ポリシールーティングの設定は pf でやるとこにしました。

以下が pf の設定です。 Server2 のは FreeBSD/amd64 10.3-RELEASE です。

/etc/pf.conf に記載します。記載したあとは service pf onestart したあとに pfctl -sa で確認できます。

pass quick on lo0 all

pass quick on vmx0 all

pass quick on em0 all

#

# NIC vmx0 -> vmx0 (IPv4)

pass out quick on vmx0 from 192.168.22.20 to 192.168.22.1/24

pass in quick on vmx0 reply-to (vmx0 192.168.22.1) from any to 192.168.22.20

pass out on vmx0 route-to vmx0 from 192.168.22.20 to any

#pass out on vmx0 route-to (vmx0 192.168.22.1) from 192.168.22.20 to any

# NIC vmx0 -> vmx0 (IPv6)

pass out quick on vmx0 from 2001:470:fe36:beef::3:1 to 2001:470:fe36:beef::1/64

pass in quick on vmx0 reply-to (vmx0 2001:470:fe36:beef::1) from any to 2001:470:fe36:beef::3:1

#pass out on vmx0 route-to vmx0 from 2001:470:fe36:beef::3:1 to any

pass out on vmx0 route-to (vmx0 2001:470:fe36:beef::1) from 2001:470:fe36:beef::3:1 to any

#

# NIC em0 -> em0 (IPv4)

pass out quick on em0 from 192.168.1.20 to 192.168.1.1/24

pass in quick on em0 reply-to (em0 192.168.1.1) from any to 192.168.1.20

pass out on em0 route-to em0 from 192.168.1.20 to any

#pass out on em0 route-to (em0 192.168.1.1) from 192.168.1.20 to any

# NIC em0 -> em0 (IPv6)

pass out quick on em0 from 3ffe:6580:aa40::3:1 to 3ffe:6580:aa40::ffff:1/64

pass in quick on em0 reply-to (em0 3ffe:6580:aa40::/64) from any to 3ffe:6580:aa40::3:1

pass out on em0 route-to em0 from 3ffe:6580:aa40::3:1 to any

#pass out on em0 route-to (em0 3ffe:6580:aa40::ffff:1) from 3ffe:6580:aa40::3:1 to any

|

・Server-Zone の IPv4 Gateway: 192.168.22.1

・Server-Zone のサーバ IPv4 アドレス: 192.168.22.20

・Server-Zone の IPv6 Gateway: 2001:470:fe36:beef::1

・Server-Zone のサーバ IPv6 アドレス: 2001:470:fe36:beef::3:1

・LAN-Zone の IPv4 Gateway: 192.168.1.1

・LAN-Zone のサーバ IPv4 アドレス: 192.168.1.20

・LAN-Zone の IPv6 Gateway: 3ffe:6580:aa40::ffff:1

・LAN-Zone のサーバ IPv6 アドレス: 3ffe:6580:aa40::3:1

これで FreeBSD の場合は IPv4/IPv6 共にパケットが届いた NIC と出ていく NIC が一緒になるかと思います。グルっと回って反対側の NIC から出ていくことはなくなります。

僕は pf についていまいち解ってないのですが、 pass out on vmx0 route-to のオプションで (NIC Gateway) の設定があるのですが、この場合は vmx0 の 192.168.22.1 なゲートウェイアドレスに転送するよ。って設定ぽいですね。その場合、同一セグメント上の送信元、俗に言う、コネクテッドなホストには届かないんでないの? って気がするので (NIC Gateway) の記述ではなく () をはずして NIC のみを記載しています。

1).コネクテッドなホストと通信ができて、ゲートウェイの先のホストと通信ができない設定

pass out on em0 route-to em0 from 192.168.1.10 to any

pass out on em0 route-to em0 from 2405:6580:aa40::2:1 to any

|

2).ゲートウェイの先のホストと通信ができて、コネクテッドなホストと通信ができない設定

pass out on em0 route-to (em0 192.168.1.1) from 192.168.1.10 to any

pass out on em0 route-to (em0 3ffe:6580:aa40::ffff:1) from 3ffe:6580:aa40::2:1 to any

|

IPv4 の LAN-Zone なアドレスは外と通信することが無いので 1). の設定で十分な気がします。

IPv6 アドレスの場合、LAN-Zone は守りたいので 1). のほうが良いかな。

こーいうのを意識せずに、ゲートウェイの先のホストとコネクテッドなホストの両方と通信できる設定ってできるのかしら? その点 Linux は良い感じに動作していると思うんですけども。

ポリシールーティングの設定の場合、入ってきた NIC の先の Gateway に返す。ってのはウェブでまぁ、ほどほど見かけるのですが、僕から言わせてもらうと『入って来た NIC から出ていってくれてるだけで良いよ。』ってのが素直な感想なのだけど、そーは行かないのかな?

設定が完了したら pfctl -sa してみたり tcpdump -i vmx0 で確認してみると、パケットは入って来たポートから出ていくし、コネクテッドなホストとも無事に通信ができています。まぁ、この設定でヨシとしておきましょう。

あと、今回の検証のために FreeBSD の VRF の技術でもある setfib を試しましたが IPv6 が使えないのね・・。

そして、fib ごとにルーティングテーブルが個別になると思うんだけど、どうして別の fib のルーティング情報も見えるんだろう? fib はインターフェースとリンクしなくて良いのかな? 不思議だ・・。

$ setfib 0 netstat -nr -f inet

Routing tables

Internet:

Destination Gateway Flags Netif Expire

default 192.168.22.1 UGS ue0

127.0.0.1 link#1 UH lo0

192.168.1.0/24 link#3 U wlan0

192.168.1.33 link#3 UHS lo0

192.168.22.0/24 link#2 U ue0

192.168.22.33 link#2 UHS lo0

$ setfib 1 netstat -nr -f inet

Routing tables (fib: 1)

Internet:

Destination Gateway Flags Netif Expire

default 192.168.1.1 UGS wlan0

127.0.0.1 link#1 UH lo0

192.168.1.0/24 link#3 U wlan0

192.168.22.0/24 link#2 U ue0

|

(fib: 0) 側に 192.168.1.0/24 のルーティング情報が乗っていたら意味ないし、 (fib: 1) に 192.168.22.0/24 の情報があったら、ダメなような気がするんだけど・・。 ue0 から入ってきたパケットは wlan0 に抜けていってしまうと思われる・・。

setfib って、二つ (fib の数だけ) のルーティングテーブルを持つことができる。って機能ではないのかしら?

ルーティングテーブルがこんな具合になってくれていると多分 pf によるポリシールーティングは必要ないのではないか。と思われます。

$ setfib 0 netstat -nr -f inet

Routing tables (fib: 0)

Destination Gateway Flags Netif Expire

default 192.168.22.1 UGS ue0

127.0.0.1 link#1 UH lo0

192.168.22.0/24 link#2 U ue0

192.168.22.33 link#3 UHS lo0

$ setfib 1 netstat -nr -f inet

Routing tables (fib: 1)

Destination Gateway Flags Netif Expire

default 192.168.1.1 UGS wlan0

127.0.0.1 link#1 UH lo0

192.168.1.0/24 link#2 U wlan0

192.168.1.33 link#3 UHS lo0

|